Miguel Carrasco, académico de la Facultad de Ingeniería y Ciencias de la Universidad Adolfo Ibáñez, ha colaborado con un investigador español para desarrollar una encuesta que utiliza inteligencia artificial para interpretar emociones a través de arte generativo. Esta innovadora herramienta podría aplicarse en el futuro para proporcionar acompañamiento seguro a adultos mayores y personas vulnerables que viven solas.

Este estudio colaborativo entre la Universidad Adolfo Ibáñez y la Universidad de Córdoba emplea herramientas de la Inteligencia Artificial (IA) para crear una encuesta que interpreta emociones a partir de la percepción de obras artísticas digitalizadas. Este método, denominado “arte generativo”, fue testeado con 61 participantes de siete países, que incluyeron a 33 hombres y 28 mujeres. Cada participante evaluó de forma independiente las obras, lo que permitió a los investigadores proyectar la utilidad de esta metodología para identificar cambios emocionales en personas vulnerables que viven en aislamiento y ofrecer ayuda oportuna.

La investigación fue liderada en Chile por Carrasco, junto a Raúl Dastres, Magíster en Ciencias de la Ingeniería de la UAI, y el Dr. César González-Martín, investigador de la Facultad de Ciencias de la Educación y Psicología de la Universidad de Córdoba.

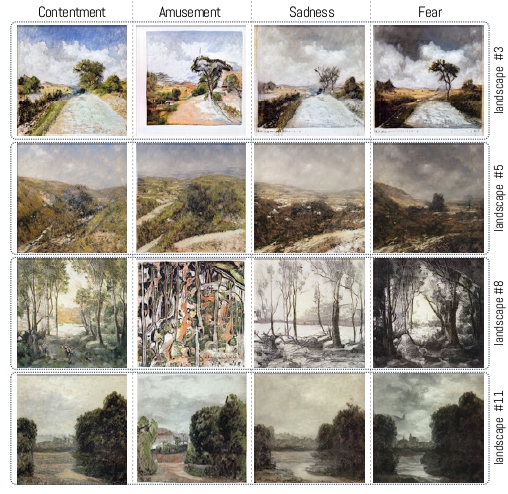

Los académicos desarrollaron un algoritmo llamado StyleGan ADA2 que genera emociones y fue entrenado con datos reales, donde muchos participantes identificaron una emoción específica para las mismas obras. Este enfoque permite al algoritmo crear imágenes artificiales que se asemejan a este entrenamiento. Carrasco destaca que, dado que todas las imágenes son completamente originales y no han sido vistas anteriormente por los participantes, la evaluación de las mismas es ciega, garantizando que los observadores no tengan conocimiento previo sobre la asignación emocional.

El estudio tiene como objetivo comprender cómo el arte generativo puede evocar emociones en los espectadores, y teorizar sobre el hecho de que las imágenes artificiales generan respuestas en el observador según la emoción para la que fueron creadas. “Generamos 20 paisajes artificiales y creamos cuatro versiones emocionales de cada uno: alegre, divertido, triste y temeroso. En total, se replicaron 80 imágenes inspiradas en la pintura, diseñadas para evocar sentimientos en los encuestados”, explica Carrasco.

En cuanto a los hallazgos, los investigadores analizaron la concordancia en las respuestas entre los participantes. Encontraron que, al separar las emociones en positivas y negativas, existía un alto nivel de acuerdo. Sin embargo, al dividirlas en las cuatro categorías emocionales, este nivel de acuerdo disminuyó, independientemente del género, área de estudio o nivel de formación profesional.

“Este hallazgo se explica por el alto nivel de subjetividad al interpretar una emoción a partir de una imagen. No obstante, la parte más relevante del estudio es el alto nivel de acuerdo entre los participantes con respecto a las imágenes generadas artificialmente, especialmente al separarlas en positivas y negativas. Las emociones negativas (triste y temeroso) son más fáciles de interpretar que las positivas (alegre, divertido)”, precisa Carrasco.

A largo plazo, el académico espera mejorar los modelos que generan emociones acordes a la interpretación humana. La subjetividad en el área de las emociones implica que los modelos deben captar elementos esenciales de dicha subjetividad, incluyendo la mayor cantidad de elementos visibles y/o interpretables para el observador. “Este avance permitiría que una máquina interprete imágenes o videos de la misma manera que lo hace un observador humano, lo cual sería un aporte significativo en modelos de acompañamiento remoto para adultos mayores o personas en situación de vulnerabilidad física, mental y emocional”, sostiene el profesor Carrasco.

El estudio actualmente se encuentra en proceso de revisión, a la espera de ser publicado en una revista científica internacional y de socializar sus resultados en congresos.